一、常用基本命令

此文章紧接linux基础文章,如果没有安装linux,那么情先参见(linux基础 )

1.1 帮助命令

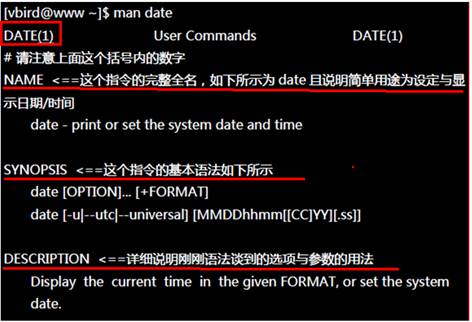

1.1.1 man 获得帮助信息

1)基本语法:

man [命令或配置文件] (功能描述:获得帮助信息)

(1)显示说明

NAME 命令的名称和单行描述

SYNOPSIS 怎样使用命令

DESCRIPTION 命令功能的深入讨论

EXAMPLES 怎样使用命令的例子

SEE ALSO 相关主题(通常是手册页)

(2)数字说明

1.用户在shell环境中可以操作的命令或是可执行的文件

2.系统内核(kernel)可以调用的函数

3.常用的函数or函数库

4.设备配置文件

5.配置文件的格式

6.游戏相关

7.linux网络协议和文件系统

8.系统管理员可以用的命令

9.跟内核有关系的文件

2)案例

[root@hadoop106 home]# man ls

1.1.2 help 获得shell内置命令的帮助信息

1)基本语法:

help 命令 (功能描述:获得shell内置命令的帮助信息)

2)案例:

[root@hadoop101 bin]# help cd

1.1.3 常用快捷键

1)ctrl + c:停止进程

2)ctrl+l:清屏

3)ctrl + q:退出

4)善于用tab键

5)上下键:查找执行过的命令

6)ctrl +alt:linux和Windows之间切换

1.2 文件目录类

1.2.1 pwd 显示当前工作目录的绝对路径

1)基本语法:

pwd (功能描述:显示当前工作目录的绝对路径)

2)案例

[root@hadoop101 home]# pwd

/home

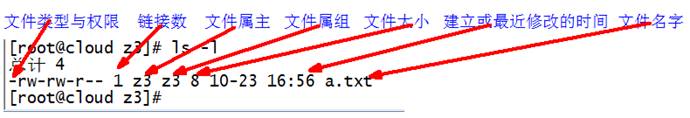

1.2.2 ls 列出目录的内容

1)基本语法:

ls [选项] [目录或是文件]

选项:

-a :全部的文件,连同隐藏档( 开头为 . 的文件) 一起列出来(常用)

-l :长数据串列出,包含文件的属性与权限等等数据;(常用)

每行列出的信息依次是: 文件类型与权限 链接数 文件属主 文件属组 文件大小用byte来表示 建立或最近修改的时间 名字

2)案例

[kingge@hadoop101 ~]$ ls -al

总用量 44

drwx——. 5 kingge kingge 4096 5月 27 15:15 .

drwxr-xr-x. 3 root root 4096 5月 27 14:03 ..

drwxrwxrwx. 2 root root 4096 5月 27 14:14 hello

-rwxrw-r–. 1 kingge kingge 34 5月 27 14:20 test.txt

1.2.3 mkdir 创建一个新的目录

1)基本语法:

mkdir [-p] 要创建的目录

选项:

-p:创建多层目录

2)案例

[root@hadoop101 opt]# mkdir test

[root@hadoop101 opt]# mkdir -p user/kingge

1.2.4 rmdir 删除一个空的目录

1)基本语法:

rmdir 要删除的空目录

2)案例

[root@hadoop101 opt]# mkdir test

[root@hadoop101 opt]# rmdir test

1.2.5 touch 创建空文件

1)基本语法:

touch 文件名称

2)案例

[root@hadoop101 opt]# touch test.java

1.2.6 cd 切换目录

1)基本语法:

(1)cd 绝对路径

(2)cd 相对路径

(3)cd ~或者cd (功能描述:回到自己的家目录)

(4)cd - (功能描述:回到上一次所在目录)

(5)cd .. (功能描述:回到当前目录的上一级目录)

(6)cd -P (功能描述:跳转到实际物理路径,而非快捷方式路径)

2)案例

(1)使用 mkdir 命令创建kingge目录

[root@hadoop101 ~]# mkdir kingge

(2)使用绝对路径切换到kingge目录

[root@hadoop101 ~]# cd /root/kingge/

(3)使用相对路径切换到kingge目录

[root@hadoop101 ~]# cd ./kingge/

(4)表示回到自己的家目录,亦即是 /root 这个目录

[root@hadoop101 kingge]# cd ~

(5)cd- 回到上一次所在目录

[root@hadoop101 kingge]# cd -

(6)表示回到当前目录的上一级目录,亦即是 /root 的上一级目录的意思;

[root@hadoop101 ~]# cd ..

1.2.7 cp 复制文件或目录

1)基本语法:

(1)cp source dest (功能描述:复制source文件到dest)

(2)cp -r sourceFolder targetFolder (功能描述:递归复制整个文件夹)

2)案例

(1)复制文件

[root@hadoop101 opt]# cp test.java test

(2)递归复制整个文件夹

[root@hadoop101 opt]# cp -r test test1

1.2.8 rm 移除文件或目录

1)基本语法

(1)rmdir deleteEmptyFolder (功能描述:删除空目录)

(2)rm -rf deleteFile (功能描述:递归删除目录中所有内容)

2)案例

1)删除空目录

[root@hadoop101 opt]# rmdir test

2)递归删除目录中所有内容

[root@hadoop101 opt]# rm -rf test1

1.2.9 mv 移动文件与目录或重命名

1)基本语法:

(1)mv oldNameFile newNameFile (功能描述:重命名)

(2)mv /temp/movefile /targetFolder (功能描述:递归移动文件)

2)案例:

1)重命名

[root@hadoop101 opt]# mv test.java test1.java

2)移动文件

[root@hadoop101 opt]# mv test1.java test1

1.2.10 cat 查看文件内容

查看文件内容,从第一行开始显示。

1)基本语法

cat [选项] 要查看的文件

选项:

-A :相当于 -vET 的整合选项,可列出一些特殊字符而不是空白而已;

-b :列出行号,仅针对非空白行做行号显示,空白行不标行号!

-E :将结尾的断行字节 $ 显示出来;

-n :列出行号,连同空白行也会有行号,与 -b 的选项不同;

-T :将 [tab] 按键以 ^I 显示出来;

-v :列出一些看不出来的特殊字符

2)案例

[kingge@hadoop101 ~]$ cat -A test.txt

hellda $

dasadf ^I$

da^I^I^I$

das$

1.2.11 tac查看文件内容

查看文件内容,从最后一行开始显示,可以看出 tac 是 cat 的倒著写。

1)基本语法:

tac [选项参数] 要查看的文件

2)案例

[root@hadoop101 test1]# cat test1.java

hello

kingge

kingge1

[root@hadoop101 test1]# tac test1.java

kingge1

kingge

hello

1.2.12 more 查看文件内容

查看文件内容,一页一页的显示文件内容。

1)基本语法:

more 要查看的文件

2)功能使用说明

空白键 (space):代表向下翻一页;

Enter:代表向下翻『一行』;

q:代表立刻离开 more ,不再显示该文件内容。

Ctrl+F 向下滚动一屏

Ctrl+B 返回上一屏

= 输出当前行的行号

:f 输出文件名和当前行的行号

3)案例

[root@hadoop101 test1]# more test1.java

1.2.13 less 查看文件内容

less 的作用与 more 十分相似,都可以用来浏览文字档案的内容,不同的是 less 允许使用[pageup] [pagedown]往回滚动。

1)基本语法:

less 要查看的文件

2)功能使用说明

空白键 :向下翻动一页;

[pagedown]:向下翻动一页;

[pageup] :向上翻动一页;

/字串 :向下搜寻『字串』的功能;n:向下查找;N:向上查找;

?字串 :向上搜寻『字串』的功能;n:向上查找;N:向下查找;

q :离开 less 这个程序;

3)案例

[root@hadoop101 test1]# less test1.java

1.2.14 head查看文件内容

查看文件内容,只看头几行。

1)基本语法

head -n 10 文件 (功能描述:查看文件头10行内容,10可以是任意行数)

2)案例

[root@hadoop101 test1]# head -n 2 test1.java

hello

kingge

1.2.15 tail 查看文件内容

查看文件内容,只看尾巴几行。

1)基本语法

(1)tail -n 10 文件 (功能描述:查看文件头10行内容,10可以是任意行数)

(2)tail -f 文件 (功能描述:实时追踪该文档的所有更新)

2)案例

(1)查看文件头1行内容

[root@hadoop101 test1]# tail -n 1 test1.java

kingge

(2)实时追踪该档的所有更新

[root@hadoop101 test1]# tail -f test1.java

hello

kingge

kingge

1.2.16 重定向命令

1)基本语法:

(1)ls -l >文件 (功能描述:列表的内容写入文件a.txt中(覆盖写))

(2)ls -al >>文件 (功能描述:列表的内容追加到文件aa.txt的末尾)

2)案例

(1)[root@hadoop101 opt]# ls -l>t.txt

(2)[root@hadoop101 opt]# ls -l>>t.txt

(3)[root@hadoop101 test1]# echo hello>>test1.java

1.2.17 echo

1)基本语法:

(1)echo 要显示的内容 >> 存储内容的的文件 (功能描述:将要显示的内容,存储到文件中)

(2)echo 变量 (功能描述:显示变量的值)

2)案例

[root@hadoop101 test1]# echo $JAVA_HOME

/opt/module/jdk1.7.0_79

1.2.18 ln软链接

1)基本语法:

ln -s [原文件] [目标文件] (功能描述:给原文件创建一个软链接,软链接存放在目标文件目录)

删除软链接: rm -rf kingge,而不是rm -rf kingge/

2)案例:

[root@hadoop101 module]# ln -s /opt/module/test.txt /opt/t.txt

[root@hadoop101 opt]# ll

lrwxrwxrwx. 1 root root 20 6月 17 12:56 t.txt -> /opt/module/test.txt

创建一个软链接

[kingge@hadoop101 opt]$ ln -s /opt/module/hadoop-2.7.2/ /opt/software/hadoop

cd不加参数进入是软链接的地址

[kingge@hadoop101 software]$ cd hadoop

[kingge@hadoop101 hadoop]$ pwd

/opt/software/hadoop

cd加参数进入是实际的物理地址

[kingge@hadoop101 software]$ cd -P hadoop

[kingge@hadoop101 hadoop-2.7.2]$ pwd

/opt/module/hadoop-2.7.2

1.2.19 history查看所敲命令历史

1)基本语法:

history

2)案例

[root@hadoop101 test1]# history

1.3 时间日期类

1)基本语法

date [OPTION]… [+FORMAT]

1.3.1 date显示当前时间

1)基本语法:

(1)date (功能描述:显示当前时间)

(2)date +%Y (功能描述:显示当前年份)

(3)date +%m (功能描述:显示当前月份)

(4)date +%d (功能描述:显示当前是哪一天)

(5)date +%Y%m%d date +%Y/%m/%d … (功能描述:显示当前年月日各种格式 )

(6)date “+%Y-%m-%d %H:%M:%S” (功能描述:显示年月日时分秒)

2)案例

[root@hadoop101 /]# date

2017年 06月 19日 星期一 20:53:30 CST

[root@hadoop101 /]# date +%Y%m%d

20170619

[root@hadoop101 /]# date “+%Y-%m-%d %H:%M:%S”

2017-06-19 20:54:58

1.3.2 date显示非当前时间

1)基本语法:

(1)date -d ‘1 days ago’ (功能描述:显示前一天日期)

(2)date -d yesterday +%Y%m%d (同上)

(3)date -d next-day +%Y%m%d (功能描述:显示明天日期)

(4)date -d ‘next monday’ (功能描述:显示下周一时间)

2)案例:

[root@hadoop101 /]# date -d ‘1 days ago’

2017年 06月 18日 星期日 21:07:22 CST

[root@hadoop101 /]# date -d next-day +%Y%m%d

20170620

[root@hadoop101 /]# date -d ‘next monday’

2017年 06月 26日 星期一 00:00:00 CST

1.3.3 date设置系统时间

1)基本语法:

date -s 字符串时间

2)案例

[root@hadoop106 /]# date -s “2017-06-19 20:52:18”

1.3.4 cal查看日历

1)基本语法:

cal [选项] (功能描述:不加选项,显示本月日历)

选项:

-3 ,显示系统前一个月,当前月,下一个月的日历

具体某一年,显示这一年的日历。

2)案例:

[root@hadoop101 /]# cal

[root@hadoop101 /]# cal -3

[root@hadoop101 /]# cal 2016

1.4 用户管理命令

1.4.1 useradd 添加新用户

1)基本语法:

useradd 用户名 (功能描述:添加新用户)

2)案例:

[root@hadoop101 opt]# user kingge

1.4.2 passwd 设置用户密码

1)基本语法:

passwd 用户名 (功能描述:设置用户密码)

2)案例

[root@hadoop101 opt]# passwd kingge

1.4.3 id 判断用户是否存在

1)基本语法:

id 用户名

2)案例:

[root@hadoop101 opt]#id kingge

1.4.4 su 切换用户

1)基本语法:

su 用户名称 (功能描述:切换用户,只能获得用户的执行权限,不能获得环境变量)

su - 用户名称 (功能描述:切换到用户并获得该用户的环境变量及执行权限)

2)案例

[root@hadoop101 opt]#su kingge

[root@hadoop101 opt]#su - kingge

1.4.5 userdel 删除用户

1)基本语法:

(1)userdel 用户名 (功能描述:删除用户但保存用户主目录)

(2)userdel -r 用户名 (功能描述:用户和用户主目录,都删除)

2)案例:

(1)删除用户但保存用户主目录

[root@hadoop101 opt]#userdel kingge

(2)删除用户和用户主目录,都删除

[root@hadoop101 opt]#userdel -r kingge

1.4.6 who 查看登录用户信息

1)基本语法

(1)whoami (功能描述:显示自身用户名称)

(2)who am i (功能描述:显示登录用户的用户名)

(3)who (功能描述:看当前有哪些用户登录到了本台机器上)

2)案例

[root@hadoop101 opt]# whoami

[root@hadoop101 opt]# who am i

[root@hadoop101 opt]# who

1.4.7 设置kingge普通用户具有root权限

1)修改配置文件

修改 /etc/sudoers 文件,找到下面一行,在root下面添加一行,如下所示:

Allow root to run any commands anywhere root ALL=(ALL) ALL kingge ALL=(ALL) ALL

或者配置成采用sudo命令时,不需要输入密码

Allow root to run any commands anywhere root ALL=(ALL) ALL kingge ALL=(ALL) NOPASSWD:ALL

修改完毕,现在可以用kingge帐号登录,然后用命令 su - ,即可获得root权限进行操作。

2)案例

[kingge@hadoop101 opt]$ sudo mkdir module

[root@hadoop101 opt]# chown kingge:kingge module/

1.4.8 cat /etc/passwd 查看创建了哪些用户

cat /etc/passwd

1.4.9 usermod修改用户

1)基本语法:

usermod -g 用户组 用户名

2)案例:

将用户kingge加入dev用户组

[root@hadoop101 opt]#usermod -g dev kingge

1.5 用户组管理命令

每个用户都有一个用户组,系统可以对一个用户组中的所有用户进行集中管理。不同Linux 系统对用户组的规定有所不同,

如Linux下的用户属于与它同名的用户组,这个用户组在创建用户时同时创建。

用户组的管理涉及用户组的添加、删除和修改。组的增加、删除和修改实际上就是对/etc/group文件的更新。

1.5.1 groupadd 新增组

1)基本语法

groupadd 组名

2)案例:

添加一个kingge组

[root@hadoop101 opt]#groupadd kingge

1.5.2 groupdel删除组

1)基本语法:

groupdel 组名

2)案例

[root@hadoop101 opt]# groupdel kingge

1.5.3 groupmod修改组

1)基本语法:

groupmod -n 新组名 老组名

2)案例

修改kingge组名称为kingge1

[root@hadoop101 kingge]# groupmod -n kingge1 kingge

1.5.4 cat /etc/group 查看创建了哪些组

cat /etc/group

1.5.5 综合案例

[root@hadoop101 kingge]# groupadd dev

[root@hadoop101 kingge]# groupmod -n device dev

[root@hadoop101 kingge]# usermod -g device kingge

[root@hadoop101 kingge]# su kingge

[kingge@hadoop101 ~]$ mkdir kingge

[kingge@hadoop101 ~]$ ls -l

drwxr-xr-x. 2 kingge device 4096 5月 27 16:31 kingge

[root@hadoop101 kingge]# usermod -g kingge kingge

1.6 文件权限类

1.6.1 文件属性

Linux系统是一种典型的多用户系统,不同的用户处于不同的地位,拥有不同的权限。为了保护系统的安全性,Linux系统对不同的用户访问同一文件(包括目录文件)的权限做了不同的规定。在Linux中我们可以使用ll或者ls –l命令来显示一个文件的属性以及文件所属的用户和组。

1)从左到右的10个字符表示:

如果没有权限,就会出现减号[ - ]而已。从左至右用0-9这些数字来表示:

(1)0首位表示类型

在Linux中第一个字符代表这个文件是目录、文件或链接文件等等

- 代表文件

d 代表目录

c 字符流,装置文件里面的串行端口设备,例如键盘、鼠标(一次性读取装置)

s socket

p 管道

l 链接文档(link file);

b 设备文件,装置文件里面的可供储存的接口设备(可随机存取装置)

(2)第1-3位确定属主(该文件的所有者)拥有该文件的权限。—User

(3)第4-6位确定属组(所有者的同组用户)拥有该文件的权限,—Group

(4)第7-9位确定其他用户拥有该文件的权限 —Other

| 文件类型 | 属主权限 | 属组权限 | 其他用户权限 |

|---|---|---|---|

| 0 | 1 2 3 | 4 5 6 | 7 8 9 |

| d | R w x | R - x | R - x |

| 目录文件 | 读 写 执行 | 读 写 执行 | 读 写 执行 |

2)rxw作用文件和目录的不同解释

(1)作用到文件:

[ r ]代表可读(read): 可以读取,查看

[ w ]代表可写(write): 可以修改,但是不代表可以删除该文件,删除一个文件的前提条件是对该文件所在的目录有写权限,才能删除该文件.

[ x ]代表可执行(execute):可以被系统执行

(2)作用到目录:

[ r ]代表可读(read): 可以读取,ls查看目录内容

[ w ]代表可写(write): 可以修改,目录内创建+删除+重命名目录

[ x ]代表可执行(execute):可以进入该目录

3)案例

[kingge@hadoop101 ~]$ ls -l

总用量 8

drwxrwxr-x. 2 kingge kingge 4096 5月 27 14:14 hello

-rw-rw-r–. 1 kingge kingge 34 5月 27 14:20 test.txt

(1)如果查看到是文件:链接数指的是硬链接个数。创建硬链接方法

ln [原文件] [目标文件]

[root@hadoop101 xiyou]# ln sunhouzi/shz.txt ./shz.txt

(2)如果查看的是文件夹:链接数指的是子文件夹个数。

[root@hadoop101 xiyou]# ls -al kingge/

总用量 8

drwxr-xr-x. 2 root root 4096 9月 3 19:02 .

drwxr-xr-x. 5 root root 4096 9月 3 21:21 ..

1.6.2 chmod改变权限

1)基本语法:

chmod [{ugoa}{+-=}{rwx}] [文件或目录] [mode=421 ] [文件或目录]

2)功能描述

改变文件或者目录权限

文件: r-查看;w-修改;x-执行文件

目录: r-列出目录内容;w-在目录中创建和删除;x-进入目录

删除一个文件的前提条件:该文件所在的目录有写权限,你才能删除该文件。

3)案例

[root@hadoop101 test1]# chmod u+x test1.java

[root@hadoop101 test1]# chmod g+x test1.java

[root@hadoop101 test1]# chmod o+x test1.java

[root@hadoop101 test1]# chmod 777 test1.java

[root@hadoop101 test1]# chmod -R 777 testdir

1.6.3 chown改变所有者

1)基本语法:

chown [最终用户] [文件或目录] (功能描述:改变文件或者目录的所有者)

2)案例

[root@hadoop101 test1]# chown kingge test1.java

[root@hadoop101 test1]# ls -al

-rwxr-xr-x. 1 kingge kingge 551 5月 23 13:02 test1.java

修改前:

[root@hadoop101 xiyou]# ll

drwxrwxrwx. 2 root root 4096 9月 3 21:20 sunhouzi

修改后

[root@hadoop101 xiyou]# chown -R kingge:kingge sunhouzi/

[root@hadoop101 xiyou]# ll

drwxrwxrwx. 2 kingge kingge 4096 9月 3 21:20 sunhouzi

1.6.4 chgrp改变所属组

1)基本语法:

chgrp [最终用户组] [文件或目录] (功能描述:改变文件或者目录的所属组)

2)案例

[root@hadoop101 test1]# chgrp kingge test1.java

[root@hadoop101 test1]# ls -al

-rwxr-xr-x. 1 root kingge 551 5月 23 13:02 test1.java

1.6.5 su 切换用户

1)基本语法:

su -username (功能描述:切换用户)

2)案例

[root@hadoop101 kingge]# su kingge

[kingge@hadoop101 ~]$

[kingge@hadoop101 ~]$ su root

密码:

[root@hadoop101 kingge]#

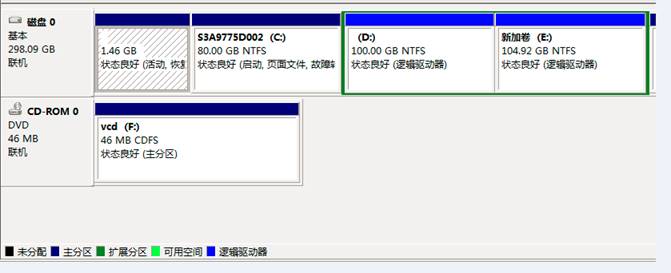

1.7 磁盘分区类

1.7.1 fdisk查看分区

1)基本语法:

fdisk -l (功能描述:查看磁盘分区详情)

注意:在root用户下才能使用

2)功能说明:

(1)Linux分区

这个硬盘是20G的,有255个磁面;63个扇区;2610个磁柱;每个 cylinder(磁柱)的容量是 8225280 bytes=8225.280 K(约为)=8.225280M(约为);

| Device | Boot | Start | End | Blocks | Id | System |

|---|---|---|---|---|---|---|

| 分区序列 | 引导 | 从X磁柱开始 | 到Y磁柱结束 | 容量 | 分区类型ID | 分区类型 |

(2)Win7分区

3)案例

[root@hadoop101 /]# fdisk -l

Disk /dev/sda: 21.5 GB, 21474836480 bytes

255 heads, 63 sectors/track, 2610 cylinders

Units = cylinders of 16065 * 512 = 8225280 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

Disk identifier: 0x0005e654

Device Boot Start End Blocks Id System

/dev/sda1 * 1 26 204800 83 Linux

Partition 1 does not end on cylinder boundary.

/dev/sda2 26 1332 10485760 83 Linux

/dev/sda3 1332 1593 2097152 82 Linux swap / Solaris

1.7.2 df查看硬盘

1)基本语法:

df 参数 (功能描述:列出文件系统的整体磁盘使用量,检查文件系统的磁盘空间占用情况)

参数:

-a :列出所有的文件系统,包括系统特有的 /proc 等文件系统;

-k :以 KBytes 的容量显示各文件系统;

-m :以 MBytes 的容量显示各文件系统;

-h :以人们较易阅读的 GBytes, MBytes, KBytes 等格式自行显示;

-H :以 M=1000K 取代 M=1024K 的进位方式;

-T :显示文件系统类型,连同该 partition 的 filesystem 名称 (例如 ext3) 也列出;

-i :不用硬盘容量,而以 inode 的数量来显示

2)案例

[root@hadoop101 ~]# df -h

Filesystem Size Used Avail Use% Mounted on

/dev/sda2 15G 3.5G 11G 26% /

tmpfs 939M 224K 939M 1% /dev/shm

/dev/sda1 190M 39M 142M 22% /boot

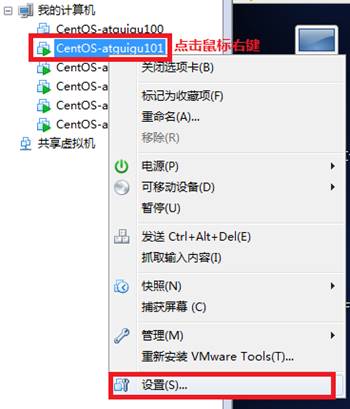

1.7.3 mount/umount挂载/卸载

对于Linux用户来讲,不论有几个分区,分别分给哪一个目录使用,它总归就是一个根目录、一个独立且唯一的文件结构

Linux中每个分区都是用来组成整个文件系统的一部分,她在用一种叫做“挂载”的处理方法,它整个文件系统中包含了一整套的文件和目录,并将一个分区和一个目录联系起来,要载入的那个分区将使它的存储空间在这个目录下获得。

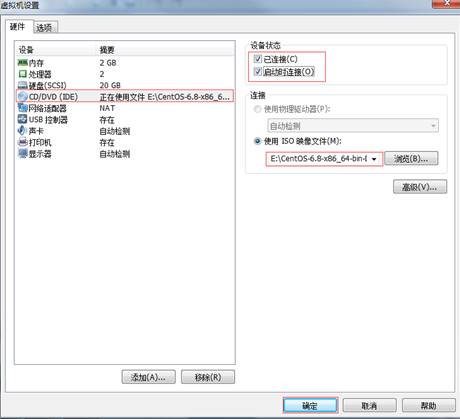

0**)挂载前准备(必须要有光盘或者已经连接镜像文件)**

1**)挂载光盘语法:**

mount [-t vfstype] [-o options] device dir

(1)-t vfstype 指定文件系统的类型,通常不必指定。mount 会自动选择正确的类型。

常用类型有:

光盘或光盘镜像:iso9660

DOS fat16文件系统:msdos

Windows 9x fat32文件系统:vfat

Windows NT ntfs文件系统:ntfs

Mount Windows文件网络共享:smbfs

UNIX(LINUX) 文件网络共享:nfs

(2)-o options 主要用来描述设备或档案的挂接方式。常用的参数有:

loop:用来把一个文件当成硬盘分区挂接上系统

ro:采用只读方式挂接设备

rw:采用读写方式挂接设备

iocharset:指定访问文件系统所用字符集

(3)device 要挂接(mount)的设备

(4)dir设备在系统上的挂接点(mount point)

2**)案例**

(1)光盘镜像文件的挂载

[root@hadoop101 ~]# mkdir /mnt/cdrom/ 建立挂载点

[root@hadoop101 ~]# mount -t iso9660 /dev/cdrom /mnt/cdrom/ 设备/dev/cdrom挂载到 挂载点 : /mnt/cdrom中

[root@hadoop101 ~]# ll /mnt/cdrom/

3**)卸载光盘语法:**

[root@hadoop101 ~]# umount 设备文件名或挂载点

4**)案例**

[root@hadoop101 ~]# umount /mnt/cdrom

5**)开机自动挂载语法:**

[root@hadoop101 ~]# vi /etc/fstab

添加红框中内容,保存退出。

1.8 搜索查找类

1.8.1 find 查找文件或者目录

1)基本语法:

find [搜索范围] [匹配条件]

2)案例

(1)按文件名:根据名称查找/目录下的filename.txt文件。

[root@hadoop101 ~]# find /opt/ -name *.txt

(2)按拥有者:查找/opt目录下,用户名称为-user的文件

[root@hadoop101 ~]# find /opt/ -user kingge

(3)按文件大小:在/home目录下查找大于200m的文件(+n 大于 -n小于 n等于)

[root@hadoop101 ~]find /home -size +204800

1.8.2 grep 过滤查找及“|”管道符

0)管道符,“|”,表示将前一个命令的处理结果输出传递给后面的命令处理

1)基本语法

grep+参数+查找内容+源文件

参数:

-c:只输出匹配行的计数。

-I:不区分大小写(只适用于单字符)。

-h:查询多文件时不显示文件名。

-l:查询多文件时只输出包含匹配字符的文件名。

-n:显示匹配行及行号。

-s:不显示不存在或无匹配文本的错误信息。

-v:显示不包含匹配文本的所有行。

2)案例

[root@hadoop101 opt]# ls | grep -n test

4:test1

5:test2

1.8.3 which 文件搜索命令

1)基本语法:

which 命令 (功能描述:搜索命令所在目录及别名信息)

2)案例

[root@hadoop101 opt]# which ls

/bin/ls

1.9 进程线程类

进程是正在执行的一个程序或命令,每一个进程都是一个运行的实体,都有自己的地址空间,并占用一定的系统资源。

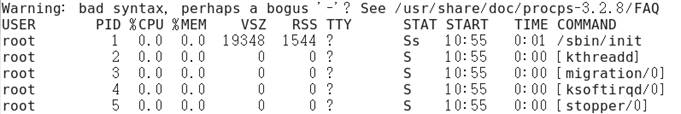

1.9.1 ps查看系统中所有进程

1)基本语法:

ps -aux (功能描述:查看系统中所有进程)

2)功能说明

USER:该进程是由哪个用户产生的

PID:进程的ID号

%CPU:该进程占用CPU资源的百分比,占用越高,进程越耗费资源;

%MEM:该进程占用物理内存的百分比,占用越高,进程越耗费资源;

VSZ:该进程占用虚拟内存的大小,单位KB;

RSS:该进程占用实际物理内存的大小,单位KB;

TTY:该进程是在哪个终端中运行的。其中tty1-tty7代表本地控制台终端,tty1-tty6是本地的字符界面终端,tty7是图形终端。pts/0-255代表虚拟终端。

STAT:进程状态。常见的状态有:R:运行、S:睡眠、T:停止状态、s:包含子进程、+:位于后台

START:该进程的启动时间

TIME:该进程占用CPU的运算时间,注意不是系统时间

COMMAND:产生此进程的命令名

3)案例

[root@hadoop101 datas]# ps -aux

1.9.2 top查看系统健康状态

1)基本命令

top [选项]

(1)选项:

-d 秒数:指定top命令每隔几秒更新。默认是3秒在top命令的交互模式当中可以执行的命令:

-i:使top不显示任何闲置或者僵死进程。

-p:通过指定监控进程ID来仅仅监控某个进程的状态。

(2)操作选项:

P: 以CPU使用率排序,默认就是此项

M: 以内存的使用率排序

N: 以PID排序

q: 退出top

(3)查询结果字段解释

第一行信息为任务队列信息

| 内容 | 说明 |

|---|---|

| 12:26:46 | 系统当前时间 |

| up 1 day, 13:32 | 系统的运行时间,本机已经运行1天 13小时32分钟 |

| 2 users | 当前登录了两个用户 |

| load average: 0.00, 0.00, 0.00 | 系统在之前1分钟,5分钟,15分钟的平均负载。一般认为小于1时,负载较小。如果大于1,系统已经超出负荷。 |

第二行为进程信息

| Tasks: 95 total | 系统中的进程总数 |

|---|---|

| 1 running | 正在运行的进程数 |

| 94 sleeping | 睡眠的进程 |

| 0 stopped | 正在停止的进程 |

| 0 zombie | 僵尸进程。如果不是0,需要手工检 查僵尸进程 |

第三行为CPU信息

| Cpu(s): 0.1%us | 用户模式占用的CPU百分比 |

|---|---|

| 0.1%sy | 系统模式占用的CPU百分比 |

| 0.0%ni | 改变过优先级的用户进程占用的CPU百分比 |

| 99.7%id | 空闲CPU的CPU百分比 |

| 0.1%wa | 等待输入/输出的进程的占用CPU百分比 |

| 0.0%hi | 硬中断请求服务占用的CPU百分比 |

| 0.1%si | 软中断请求服务占用的CPU百分比 |

| 0.0%st | st(Steal time)虚拟时间百分比。就是当有虚拟机时,虚拟CPU等待实际CPU的时间百分比。 |

第四行为物理内存信息

| Mem: 625344k total | 物理内存的总量,单位KB |

|---|---|

| 571504k used | 已经使用的物理内存数量 |

| 53840k free | 空闲的物理内存数量,我们使用的是虚拟机,总共只分配了628MB内存,所以只有53MB的空闲内存了 |

| 65800k buffers | 作为缓冲的内存数量 |

第五行为交换分区(swap)信息

| Swap: 524280k total | 交换分区(虚拟内存)的总大小 |

|---|---|

| 0k used | 已经使用的交互分区的大小 |

| 524280k free | 空闲交换分区的大小 |

| 409280k cached | 作为缓存的交互分区的大小 |

2)案例

[root@hadoop101 kingge]# top -d 1

[root@hadoop101 kingge]# top -i

[root@hadoop101 kingge]# top -p 2575

执行上述命令后,可以按P、M、N对查询出的进程结果进行排序。

1.9.3 pstree查看进程树

1)基本语法:

pstree [选项]

选项

-p: 显示进程的PID

-u: 显示进程的所属用户

2)案例:

[root@hadoop101 datas]# pstree -u

[root@hadoop101 datas]# pstree -p

1.9.4 kill终止进程

1)基本语法:

kill -9 pid进程号

选项

-9 表示强迫进程立即停止

2)案例:

启动mysql程序

切换到root用户执行

[root@hadoop101 桌面]# kill -9 5102

1.9.5 netstat显示网络统计信息

1)基本语法:

netstat -anp (功能描述:此命令用来显示整个系统目前的网络情况。例如目前的连接、数据包传递数据、或是路由表内容)

选项:

-an 按一定顺序排列输出

-p 表示显示哪个进程在调用

-nltp 查看tcp协议进程端口号

2)案例

查看端口50070的使用情况

[root@hadoop101 hadoop-2.7.2]# netstat -anp | grep 50070

tcp 0 0 0.0.0.0:50070 0.0.0.0:* LISTEN 6816/java

端口号 进程号

1.9.6 前后台进程切换

1)基本语法:

fg %1 (功能描述:把后台进程转换成前台进程)

ctrl+z bg %1 (功能描述:把前台进程发到后台)

1.10 压缩和解压类

1.10.1 gzip/gunzip压缩

1)基本语法:

gzip+文件 (功能描述:压缩文件,只能将文件压缩为*.gz文件)

gunzip+文件.gz (功能描述:解压缩文件命令)

2)特点:

(1)只能压缩文件不能压缩目录

(2)不保留原来的文件

3)案例

(1)gzip压缩

[root@hadoop101 opt]# ls

test.java

[root@hadoop101 opt]# gzip test.java

[root@hadoop101 opt]# ls

test.java.gz

(2)gunzip解压缩文件

[root@hadoop101 opt]# gunzip test.java.gz

[root@hadoop101 opt]# ls

test.java

1.10.2 zip/unzip压缩

1)基本语法:

zip + 参数 + XXX.zip + 将要压缩的内容 (功能描述:压缩文件和目录的命令,window/linux通用且可以压缩目录且保留源文件)

参数:

-r 压缩目录

2)案例:

(1)压缩 1.txt 和2.txt,压缩后的名称为mypackage.zip

[root@hadoop101 opt]# zip test.zip test1.java test.java

adding: test1.java (stored 0%)

adding: test.java (stored 0%)

[root@hadoop101 opt]# ls

test1.java test.java test.zip

(2)解压 mypackage.zip

[root@hadoop101 opt]# unzip test.zip

Archive: test.zip

extracting: test1.java

extracting: test.java

[root@hadoop101 opt]# ls

test1.java test.java test.zip

1.10.3 tar打包

1)基本语法:

tar + 参数 + XXX.tar.gz + 将要打包进去的内容 (功能描述:打包目录,压缩后的文件格式.tar.gz)

参数:

-c 产生.tar打包文件

-v 显示详细信息

-f 指定压缩后的文件名

-z 打包同时压缩

-x 解包.tar文件

2)案例

(1)压缩:tar -zcvf XXX.tar.gz n1.txt n2.txt

压缩多个文件

[root@hadoop101 opt]# tar -zcvf test.tar.gz test1.java test.java

test1.java

test.java

[root@hadoop101 opt]# ls

test1.java test.java test.tar.gz

压缩目录

[root@hadoop101 opt]# tar -zcvf test.java.tar.gz test1

test1/

test1/hello

test1/test1.java

test1/test/

test1/test/test.java

[root@hadoop106 opt]# ls

test1 test.java.tar.gz

(2)解压:tar -zxvf XXX.tar.gz

解压到当前目录

[root@hadoop101 opt]# tar -zxvf test.tar.gz

解压到/opt目录

[root@hadoop101 opt]# tar -zxvf test.tar.gz -C /opt

.11 后台服务管理类

.11.1 service后台服务管理

1)service network status 查看指定服务的状态

2)service network stop 停止指定服务

3)service network start 启动指定服务

4)service network restart 重启指定服务

5)service –status-all 查看系统中所有的后台服务

.11.2 chkconfig设置后台服务的自启配置

1)chkconfig 查看所有服务器自启配置

2)chkconfig iptables off 关掉指定服务的自动启动

3)chkconfig iptables on 开启指定服务的自动启动

1.12 crond系统定时任务

1.12.1 crond服务管理

[root@hadoop101 ~]# service crond restart (重新启动服务)

1.12.2 crontab定时任务设置

1)基本语法

crontab [选项]

选项:

-e: 编辑crontab定时任务

-l: 查询crontab任务

-r: 删除当前用户所有的crontab任务

2)参数说明

[root@hadoop101 ~]# crontab -e

(1)进入crontab编辑界面。会打开vim编辑你的工作。

* 执行的任务

| 项目 | 含义 | 范围 |

|---|---|---|

| 第一个“*” | 一小时当中的第几分钟 | 0-59 |

| 第二个“*” | 一天当中的第几小时 | 0-23 |

| 第三个“*” | 一个月当中的第几天 | 1-31 |

| 第四个“*” | 一年当中的第几月 | 1-12 |

| 第五个“*” | 一周当中的星期几 | 0-7(0和7都代表星期日) |

(2)特殊符号

| 特殊符号 | 含义 |

|---|---|

| * | 代表任何时间。比如第一个“*”就代表一小时中每分钟都执行一次的意思。 |

| , | 代表不连续的时间。比如“0 8,12,16 * 命令”,就代表在每天的8点0分,12点0分,16点0分都执行一次命令 |

| - | 代表连续的时间范围。比如“0 5 1-6命令”,代表在周一到周六的凌晨5点0分执行命令 |

| */n | 代表每隔多久执行一次。比如“/10 * 命令”,代表每隔10分钟就执行一遍命令 |

(3)特定时间执行命令

| 时间 | 含义 |

|---|---|

| 45 22 * 命令 | 在22点45分执行命令 |

| 0 17 1 命令 | 每周1 的17点0分执行命令 |

| 0 5 1,15 命令 | 每月1号和15号的凌晨5点0分执行命令 |

| 40 4 1-5 命令 | 每周一到周五的凌晨4点40分执行命令 |

| /10 4 命令 | 每天的凌晨4点,每隔10分钟执行一次命令 |

| 0 0 1,15 * 1 命令 | 每月1号和15号,每周1的0点0分都会执行命令。注意:星期几和几号最好不要同时出现,因为他们定义的都是天。非常容易让管理员混乱。 |

3)案例:

/5 * /bin/echo ”11” >> /tmp/test