5.1 Hadoop1.x和Hadoop2.x架构区别

在Hadoop1.x时代,Hadoop中的MapReduce同时处理业务逻辑运算和资源的调度,耦合性较大。

- ResourceManagement 资源管理

- JobScheduling/JobMonitoring 任务调度监控

在Hadoop2.x时代,增加了Yarn。Yarn只负责资源的调度,MapReduce只负责运算。这样就能够各司其职

- ResourceManger

- ApplicationMaster

需要注意的是,在Yarn中我们把job的概念换成了application,因为在新的Hadoop2.x中,运行的应用不只是MapReduce了,还有可能是其它应用如一个DAG(有向无环图Directed Acyclic Graph,例如storm应用)。Yarn的另一个目标就是拓展Hadoop,使得它不仅仅可以支持MapReduce计算,还能很方便的管理诸如Hive、Hbase、Pig、Spark/Shark等应用。这种新的架构设计能够使得各种类型的应用运行在Hadoop上面,并通过Yarn从系统层面进行统一的管理,也就是说,有了Yarn,各种应用就可以互不干扰的运行在同一个Hadoop系统中,共享整个集群资源。

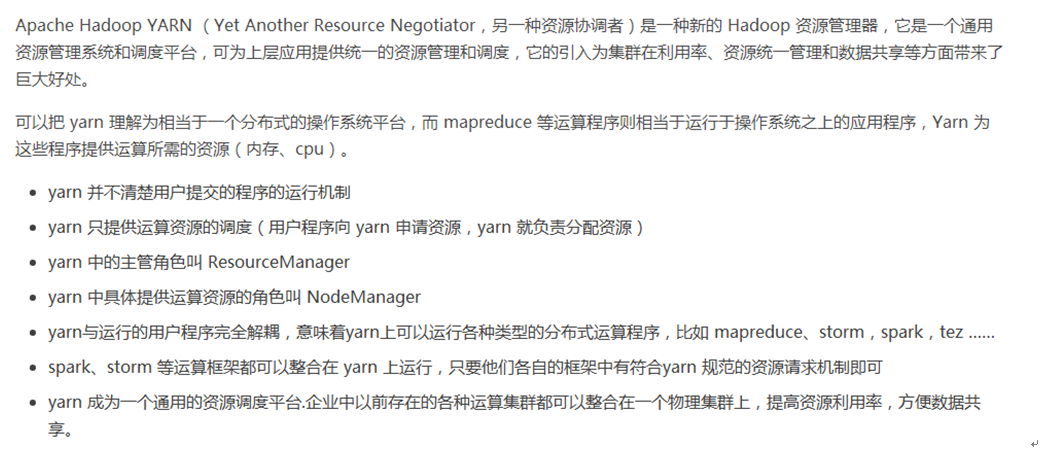

5.2 Yarn概述

Yarn是一个资源调度平台,负责为运算程序提供服务器运算资源,相当于一个分布式的操作系统平台,而MapReduce等运算程序则相当于运行于操作系统之上的应用程序。

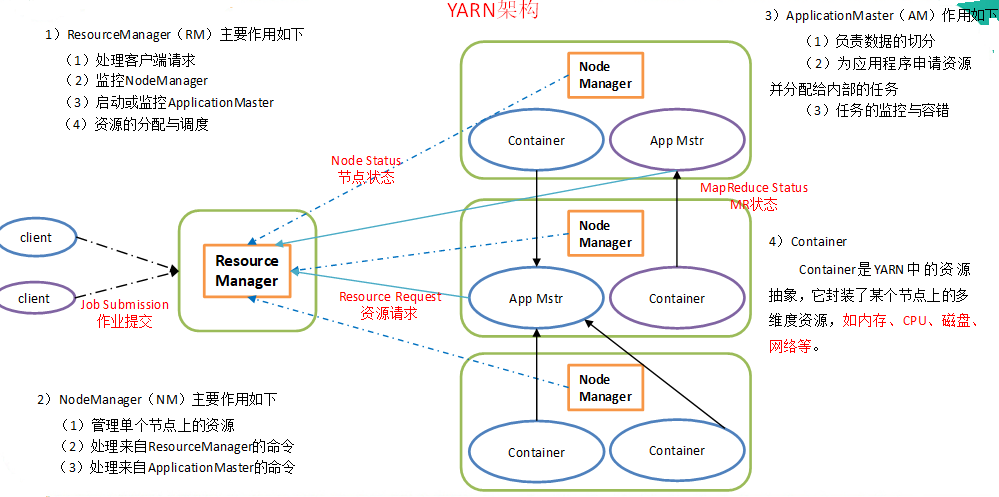

5.3 Yarn基本架构

YARN主要由ResourceManager、NodeManager、ApplicationMaster和Container等组件构成。

5.4 Yarn工作机制

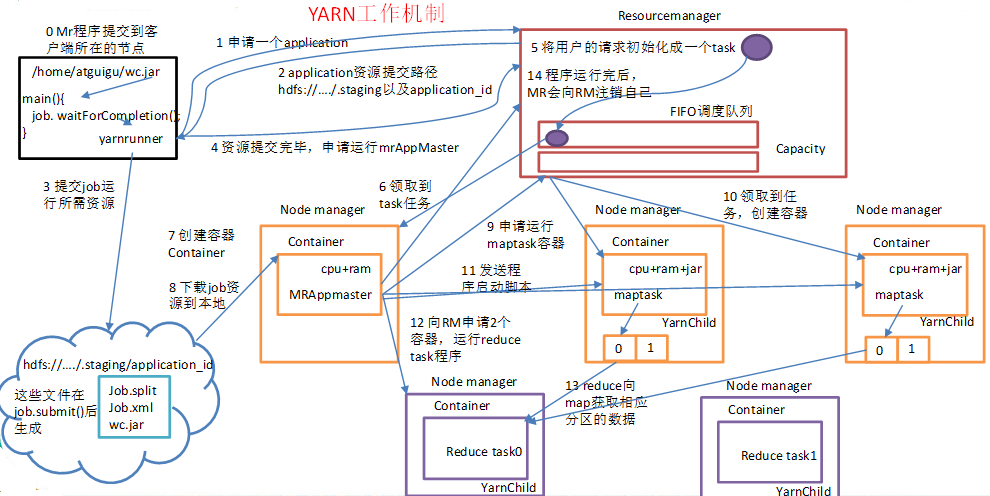

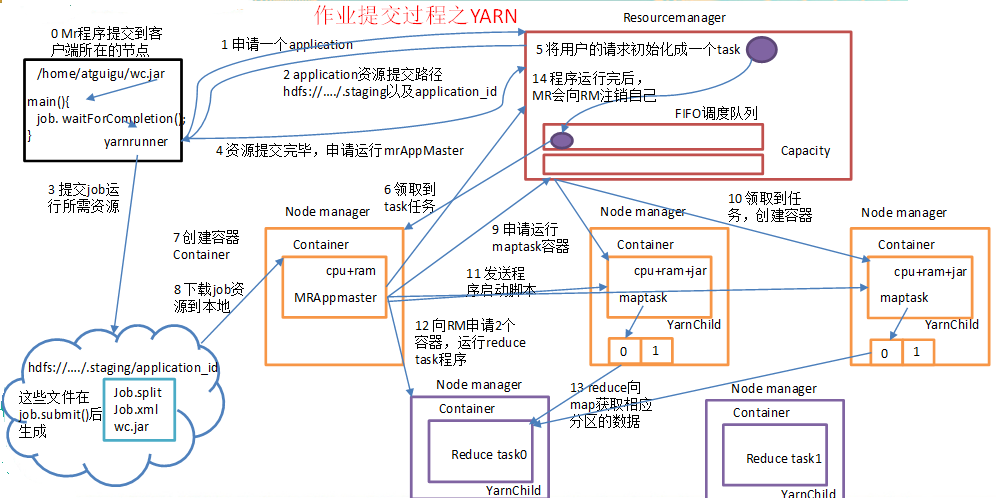

1)Yarn运行机制

2)工作机制详解

(0)Mr程序提交到客户端所在的节点。

(1)Yarnrunner向Resourcemanager申请一个Application。

(2)rm将该应用程序的资源路径返回给yarnrunner。

(3)该程序将运行所需资源提交到HDFS上。

(4)程序资源提交完毕后,申请运行mrAppMaster。

(5)RM将用户的请求初始化成一个task。

(6)其中一个NodeManager领取到task任务。

(7)该NodeManager创建容器Container,并产生MRAppmaster。

(8)Container从HDFS上拷贝资源到本地。

(9)MRAppmaster向RM 申请运行maptask资源。

(10)RM将运行maptask任务分配给另外两个NodeManager,另两个NodeManager分别领取任务并创建容器。

(11)MR向两个接收到任务的NodeManager发送程序启动脚本,这两个NodeManager分别启动maptask,maptask对数据分区排序。

(12)MrAppMaster等待所有maptask运行完毕后,向RM申请容器,运行reduce task。

(13)reduce task向maptask获取相应分区的数据。

(14)程序运行完毕后,MR会向RM申请注销自己。

5.5 作业提交全过程

1)作业提交过程之YARN

作业提交全过程详解

(1)作业提交

第0步:client调用job.waitForCompletion方法,向整个集群提交MapReduce作业。

第1步:client向RM申请一个作业id。

第2步:RM给client返回该job资源的提交路径和作业id。

第3步:client提交jar包、切片信息和配置文件到指定的资源提交路径。

第4步:client提交完资源后,向RM申请运行MrAppMaster。

(2)作业初始化

第5步:当RM收到client的请求后,将该job添加到容量调度器中。

第6步:某一个空闲的NM领取到该job。

第7步:该NM创建Container,并产生MRAppmaster。

第8步:下载client提交的资源到本地。

(3)任务分配

第9步:MrAppMaster向RM申请运行多个maptask任务资源。

第10步:RM将运行maptask任务分配给另外两个NodeManager,另两个NodeManager分别领取任务并创建容器。

(4)任务运行

第11步:MR向两个接收到任务的NodeManager发送程序启动脚本,这两个NodeManager分别启动maptask,maptask对数据分区排序。

第12步:MrAppMaster等待所有maptask运行完毕后,向RM申请容器,运行reduce task。

第13步:reduce task向maptask获取相应分区的数据。

第14步:程序运行完毕后,MR会向RM申请注销自己。

(5)进度和状态更新

YARN中的任务将其进度和状态(包括counter)返回给应用管理器, 客户端每秒(通过mapreduce.client.progressmonitor.pollinterval设置)向应用管理器请求进度更新, 展示给用户。

(6)作业完成

除了向应用管理器请求作业进度外, 客户端每5分钟都会通过调用waitForCompletion()来检查作业是否完成。时间间隔可以通过mapreduce.client.completion.pollinterval来设置。作业完成之后, 应用管理器和container会清理工作状态。作业的信息会被作业历史服务器存储以备之后用户核查。

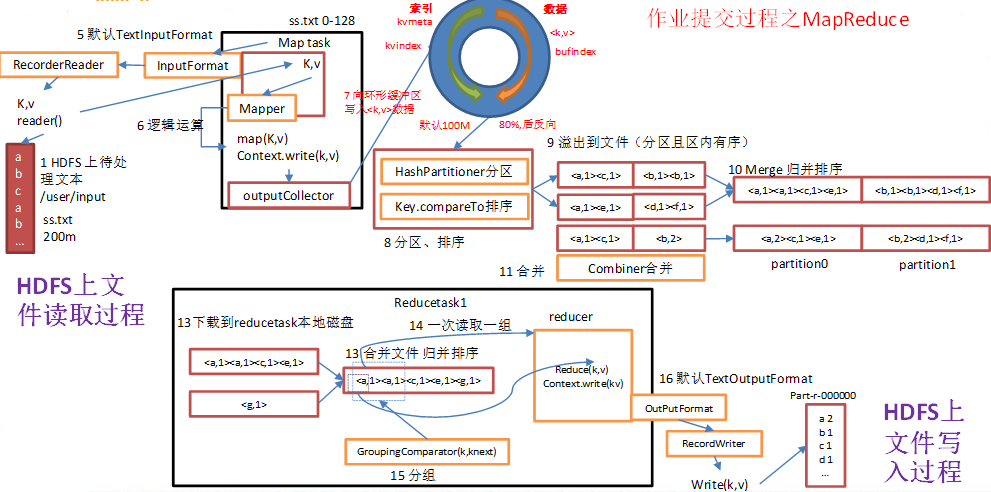

2)作业提交过程之MapReduce

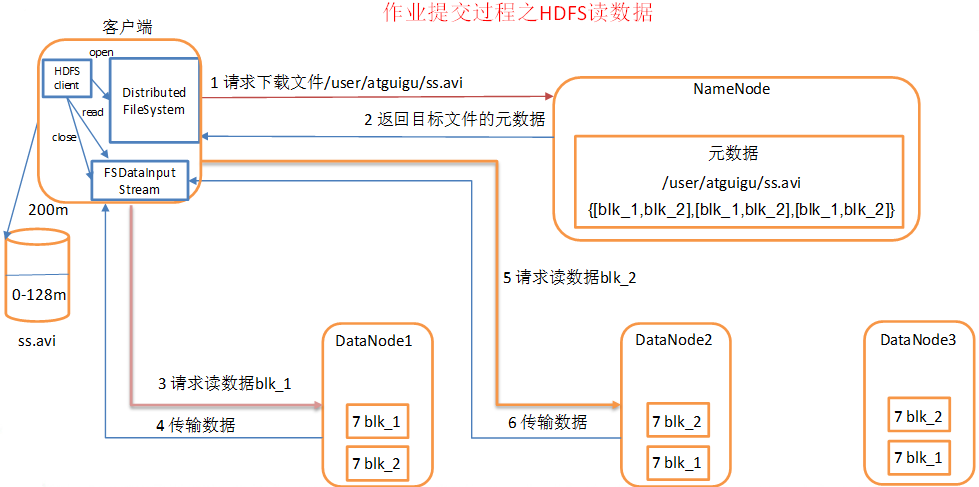

3)作业提交过程之读数据

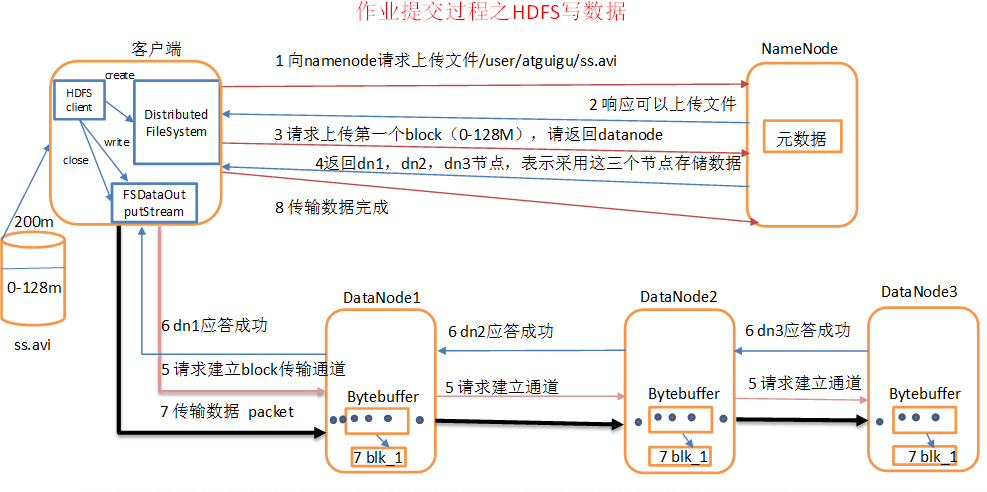

4)作业提交过程之写数据

5.6 资源调度器

目前,Hadoop作业调度器主要有三种:FIFO、Capacity Scheduler和Fair Scheduler。Hadoop2.7.2默认的资源调度器是Capacity Scheduler。

具体设置详见:yarn-default.xml文件

|

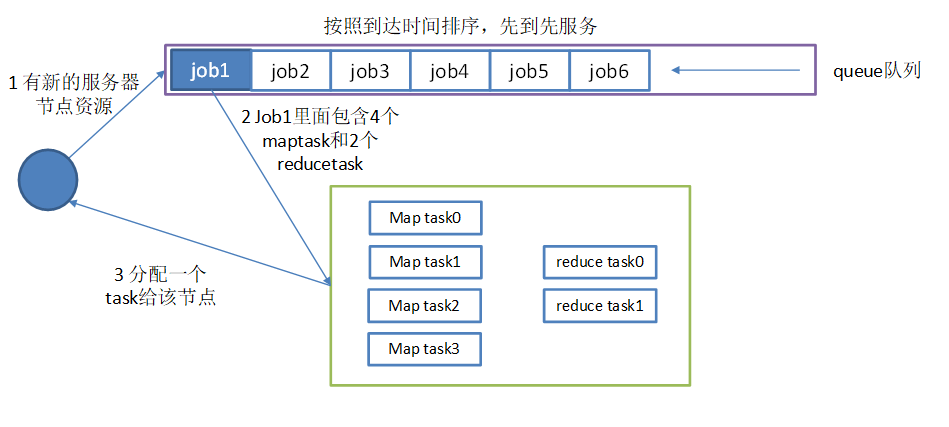

1)先进先出调度器(FIFO)

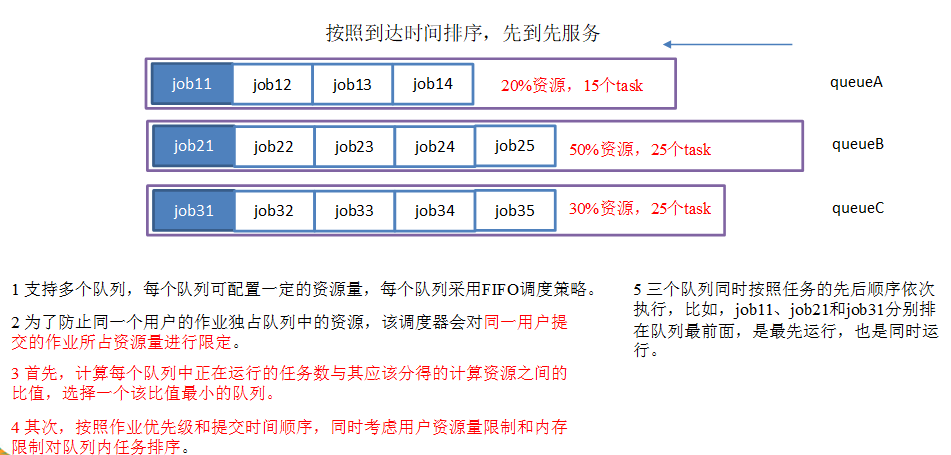

2)容量调度器(Capacity Scheduler)

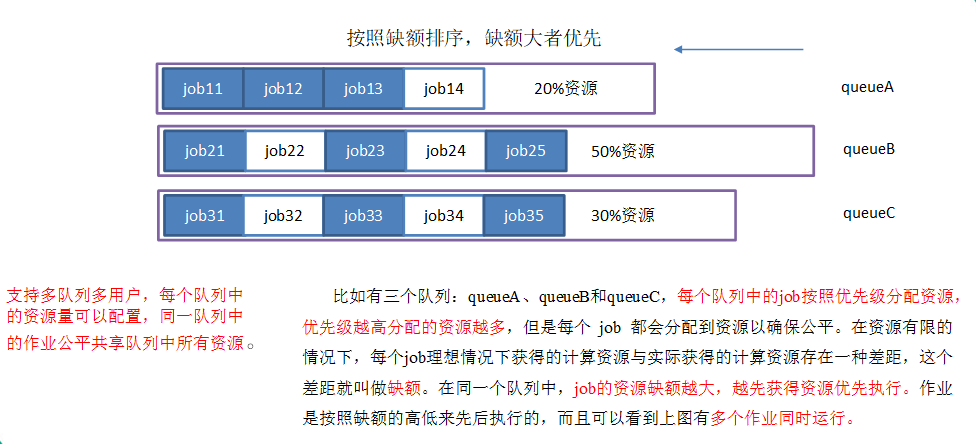

3)公平调度器(Fair Scheduler)

5.7 任务的推测执行

1)作业完成时间取决于最慢的任务完成时间

一个作业由若干个Map任务和Reduce任务构成。因硬件老化、软件Bug等,某些任务可能运行非常慢。

典型案例:系统中有99%的Map任务都完成了,只有少数几个Map老是进度很慢,完不成,怎么办?

2)推测执行机制:

发现拖后腿的任务,比如某个任务运行速度远慢于任务平均速度。为拖后腿任务启动一个备份任务,同时运行。谁先运行完,则采用谁的结果。

3)执行推测任务的前提条件

(1)每个task只能有一个备份任务;

(2)当前job已完成的task必须不小于0.05(5%)

(3)开启推测执行参数设置。Hadoop2.7.2 mapred-site.xml文件中默认是打开的。

|

4)不能启用推测执行机制情况

(1)任务间存在严重的负载倾斜;

(2)特殊任务,比如任务向数据库中写数据。

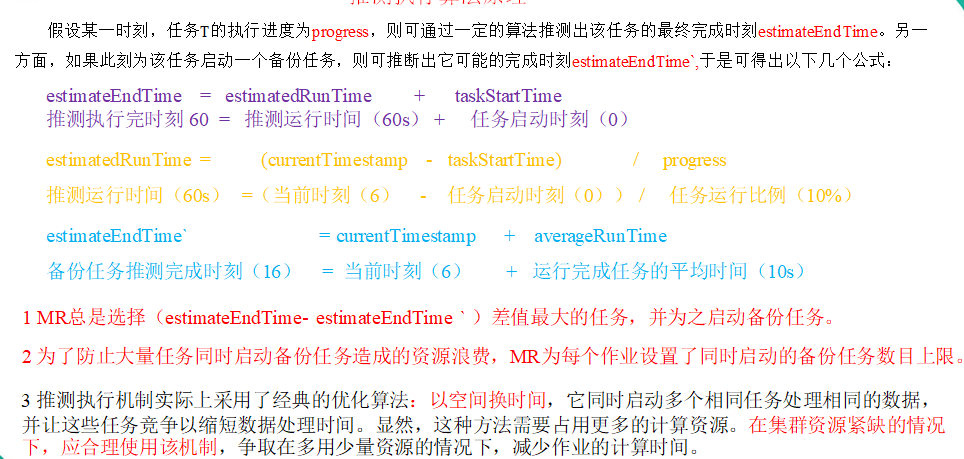

5)算法原理: